互联网技术详解 大型数据中心网络路由设计与优化(一)—— 互联网数据服务的基石

在当今数字化浪潮中,大型数据中心已成为支撑全球信息流动、云端服务与社会运转的核心引擎。无论是我们日常使用的社交媒体、流媒体视频,还是企业级的云计算、人工智能训练,其背后都依赖于庞大、复杂且高效的数据中心网络。本系列文章将深入探讨大型数据中心网络的核心——路由设计与优化。作为开篇,我们首先需要理解现代互联网数据服务对底层网络提出的根本性要求。

一、现代互联网数据服务的特征与挑战

现代互联网数据服务呈现出几个鲜明的特征,这些特征直接决定了数据中心网络架构与路由设计的走向:

- 东西向流量主导:传统企业网络流量模式以“南北向”(用户到数据中心服务器)为主。而在数据中心内部,特别是在进行分布式计算、存储同步、微服务间通信时,服务器与服务器之间产生的“东西向”流量占据了绝对主导地位,可高达总流量的70%-80%。这就要求网络必须具备极高的横向(机架间)带宽和超低的延迟。

- 海量并发与突发性:一项服务可能瞬间被全球数百万用户访问,同时内部的数据备份、MapReduce作业等也会产生突发的大数据流。网络必须具备弹性伸缩和应对“大象流”(大规模长时数据流)与“老鼠流”(大量短时小数据流)混合负载的能力。

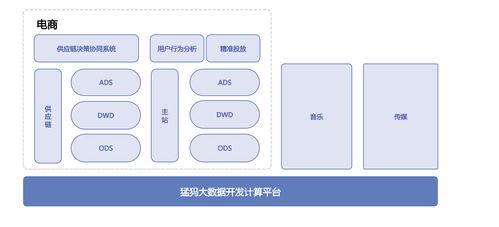

- 租户隔离与多业务承载:一个物理数据中心需要同时为成千上万个不同客户(租户)或内部不同业务部门提供服务。网络必须在共享的物理基础设施上,实现严格的流量隔离、安全边界和差异化的服务质量(QoS)保证。

- 高可用性与快速故障恢复:服务中断的代价极其高昂。网络设计必须追求“五个九”(99.999%)甚至更高的可用性,这意味着需要从设备、链路、协议各个层面实现冗余,并能在毫秒级内检测并绕开故障点。

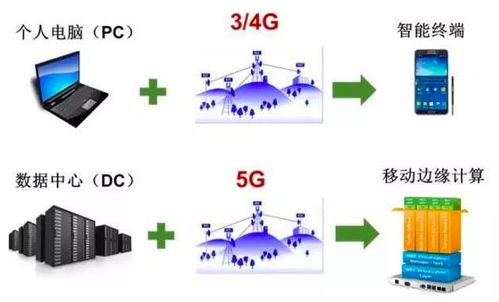

- 可扩展性与成本效率:数据中心规模持续增长,从数千台服务器扩展到数十万乃至百万台。网络架构必须能够平滑、线性地扩展,同时控制布线复杂度、设备成本和能源消耗。

二、数据中心网络路由设计的基础目标

基于上述服务需求,数据中心网络的路由设计围绕几个核心目标展开:

- 无阻塞高带宽:通过CLOS等多级交换架构,提供非 oversubscription(无超额订阅)或低超额订阅的带宽,确保任意两台服务器间都有充足的路径带宽。

- 低延迟与可预测性:路由协议和转发机制需要尽可能减少处理时延和排队时延,尤其对于金融交易、实时交互类应用,延迟的稳定性(抖动小)与绝对值同样重要。

- 高利用率与负载均衡:避免出现部分链路拥塞而部分链路闲置的情况。需要动态、高效地将流量均匀分布到所有可用的路径上,最大化网络基础设施的投资回报。

- 简化运维与自动化:面对庞大的规模,手动配置和管理不可行。路由设计需与SDN(软件定义网络)理念结合,实现集中控制、策略下发和自动化的故障响应与扩容。

三、经典架构与路由演进概述

早期数据中心普遍采用传统的三层树形架构(接入-汇聚-核心),其路由依赖生成树协议(STP)来避免环路,但这会导致大量链路被阻塞,带宽利用率低下,且收敛速度慢。

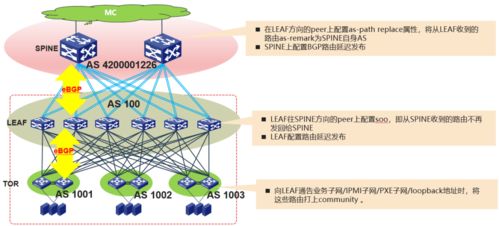

为应对东西向流量挑战,CLOS架构(或称叶脊架构)已成为现代大型数据中心的主流选择。在该架构中,每一个叶交换机(连接服务器)都与每一个脊交换机相连,形成了丰富的等代价路径。这自然地将网络路由设计的焦点从“避免环路”转向了“多路径利用”。

在此物理基础上,路由协议也随之演进:

- 二层路由的演进:从STP到TRILL、SPB等技术,试图在二层实现多路径转发。

- 三层路由的普及:直接在叶和脊交换机间运行三层路由协议(如OSPF、BGP),将整个数据中心变成一个大的IP网络,利用ECMP(等价多路径路由)来实现流量的负载分担。这种方式简化了网络,消除了大二层域带来的广播风暴风险,是目前最主流的方案。

- SDN与集中式控制:通过如BGP-SDN、P4等技术与协议,将控制平面集中,由控制器全局计算最优路径并下发流表,实现更精细、灵活的流量调度和策略实施。

###

互联网数据服务的需求是数据中心网络演进的原始驱动力。从以南北流量为主的树形结构,到为东西流量而生的叶脊架构,网络路由设计的核心思想已从“连通与防环”进化为“高效与智能”。理解了这一背景和基础目标后,我们将在后续篇章中,深入解析ECMP的具体实现、负载均衡算法、在CLOS架构中BGP的应用细节、以及SDN如何进一步优化流量工程等关键技术,揭开大型数据中心网络高效运转的神秘面纱。

如若转载,请注明出处:http://www.vrvhffg.com/product/45.html

更新时间:2026-03-01 08:44:03